Na primeira parte falei-vos dos problemas do jornalismo científico, da forma como se deve encarar a vanguarda científica, e de como o “sistema científico” actual parece promover um certo descuidado por parte dos cientistas. Nesta segunda parte irei focar-me com maior detalhe nessa negligência científica. Creio que o assunto deva ser do interesse de todos, cientistas e leigos, porque o tal “sistema” funciona na verdade com a participação de todos. Espero, em particular, que este artigo permita ao leitor aguçar o seu olhar crítico em relação às notícias que lê, sabendo ser céptico quando o deve ser.

Antes de mergulhar nas problemáticas mencionadas na primeira parte no que concerne à estatística e replicabilidade (que fica para a terceira parte), gostaria de adicionar um ponto que não sublinhei o suficiente no artigo do mês passado: o problema dos títulos sensacionalistas! O jornalismo científico por vezes até consegue estar a um nível aceitável, contando que desprezemos os títulos! A importância dos títulos para o jornalismo é inegável: o conteúdo de um artigo até pode ser muito bom, mas se o título não for suficientemente cativante, ninguém vai ler o artigo. Então é precisamente aqui que os jornalistas abusam dos seus direitos e escrevem muitas vezes mentiras descaradas. Talvez não se sintam culpados por depois, na melhor das hipóteses, tornarem claro no artigo que o título na verdade não correspondia bem à verdade. A “moral” é que nunca devem ler apenas o título!

Um bom exemplo disto foram as notícias do final do mês de Maio sobre os supostos tumores induzidos pela radiação dos telemóveis (poderá ler mais sobre o assunto aqui).

Tendo feita esta achega, encaremos os problemas estatísticos que fustigam a ciência actual.

A estatística concerne a recolha e análise de dados com base em ferramentas matemáticas aliadas à teoria de probabilidades. Uma das leis fundamentais neste ramo é a chamada Lei dos Grandes Números que nos diz que a frequência com que um dado evento ocorre tende para a probabilidade do mesmo ocorrer (ver mais detalhes no artigo A Estatística das Sondagens). Por exemplo, qual a probabilidade de sair coroa no lançamento da moeda? Intuitivamente, sabendo que existem duas hipóteses, e que cada uma deve ter igual probabilidade de sair, isso implica que haja 50% de hipóteses de sair coroa. A lei de cima diz-nos que se repetirmos a experiência de lançar a moeda ao ar muitas vezes, o número de vezes que sai coroa irá tender para metade do número total de lançamentos. Este “tender” é bastante falso, porque conduz à questão de quantas vezes são necessárias lançar a moeda para atingirmos a “verdadeira” probabilidade. A resposta insatisfatória de um ponto de vista prático, mas correcta de um ponto de vista abstracto, é infinitas vezes. Como nunca podemos repetir uma experiência infinitas vezes, isto implica que nunca podemos encontrar probabilidades definitivas através de um estudo de frequências. Note-se que o caso da moeda é simples porque sabemos calcular intuitivamente a probabilidade. Porém, o habitual é não sabermos calcular a probabilidade de um dado acontecimento, e por isso temos que nos restringir à estatística. Assim, a frequência com que um dado acontecimento ocorre pode ou não dizer-nos algo claro sobre uma característica intrínseca do acontecimento. Isto é, existe uma probabilidade não nula de chegarmos a conclusões erradas através de um estudo estatístico.

Como determinar que um dado padrão e/ou descoberta é “estatisticamente significativo”? Nos anos 20 do século passado, o matemático britânico Ronald Fisher introduziu o conceito de “p-value” (valor-p). A intenção de Fisher era criar uma ferramenta que permitisse discernir algo que podia ser significativo do ponto de vista estatístico, ainda que não necessariamente científico! Esta diferença é preponderante, porque o facto de haver algo “estatisticamente significativo” não implica de forma alguma que haja algo de significativo de um ponto de vista mais genérico. Ou seja, este p-value servia para determinar se parecia haver um padrão que justificasse um olhar mais atento sobre os dados experimentais. Seria o começo e não o fim do processo científico! (Repare-se que padrões estatísticos nunca são explicações por si mesmos, pelo que é sempre necessário descortinar o mecanismo que estabelece o “como” e o “porquê” desse padrão.)

A ideia do p-value consiste em tentar refutar a hipótese de os resultados de uma dada experiência podem ser explicados com base na aleatoriedade. Por exemplo, para verificar se o tabaco produz cancro do pulmão será natural comparar a incidência de cancro do pulmão num grupo de pessoas que fumou mais de X anos, com a incidência num grupo de não fumadores. Assim, de um ponto de vista estatístico cria-se a chamada “null hypothesis” (hipótese nula) que é não haver qualquer correlação entre fumar e ter cancro do pulmão, e como tal a incidência de cancro deve ser semelhante em ambos os grupos. Calculamos então a probabilidade de obter dados tão extremos quanto aqueles que obtivemos assumindo que a tal hipótese nula é verdadeira. Esta probabilidade é o p-value, que deve ser necessariamente muito reduzido para que possamos rejeitar a hipótese nula. Ou seja, um baixo p-value indica que há uma probabilidade reduzida de que os dados obtidos possam ser explicados com base na hipótese nula. Podemos portanto rejeitar a hipótese nula com um dado nível de confiança (normalmente usa-se 5% como o valor limiar a partir do qual tomamos a decisão de rejeitar ou não a hipótese nula). Repare-se que ao rejeitarmos a hipótese de que o cancro e o fumar não têm qualquer relação não estamos a inferir de que modo é que têm uma relação. Ao rejeitarmos uma hipótese não estamos a confirmar outra hipótese, porque nem tudo é tão simples que haja apenas preto e branco, de tal modo que se não for preto, então é branco. Podem existir imensos níveis de cinzento pelo meio que é necessário testar.

Mesmo que o tal nível de 5% possa parecer suficiente, devemos recordar que neste momento estão milhares de cientistas pelo mundo a testar diferentes hipóteses até encontrar algo que obedeça ao critério. Note-se que podemos encarar de forma simplista os 5% como sendo 5 estudos em 100 que dão resultados que são mal interpretados usando o p-value. O problema é que esses 5 estudos são publicados, e os outros 95 vão para a gaveta, por causa da não publicação de resultados “negativos”, como referi na primeira parte. Se for este o caso tornar-se-á mais fácil de publicar um desses estudos que tinha ido para a gaveta, por nessa altura já não ser simplesmente um resultado negativo, mas antes um resultado que contradiz outro publicado. Não obstante, a relação de 20 para 1 fica representada como 1 para 1 (pelo menos inicialmente). É aqui que entra a importância da replicabilidade, que irei abordar na próxima parte.

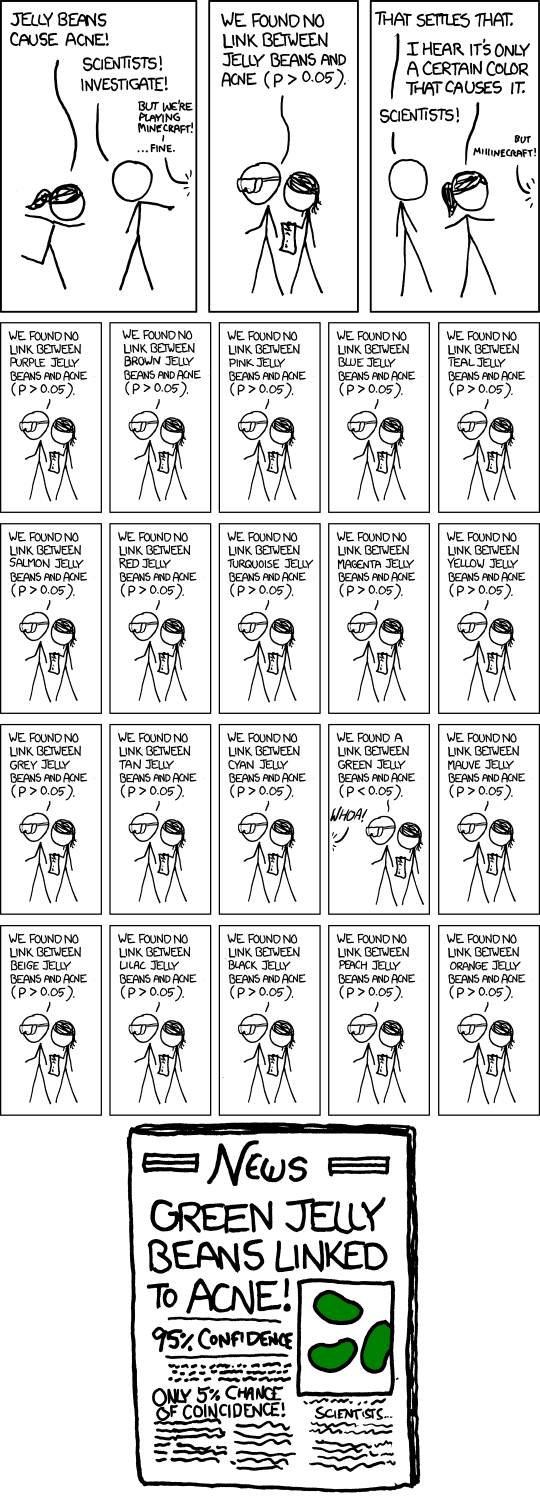

Há ainda o chamado “p-hacking”, que é semelhante ao que acabei de descrever, com a diferença de ser feito não de forma inocente por um grande número de cientistas, mas antes de forma quase criminosa por cientistas isolados! Ou seja, trata-se de testar tudo e mais alguma coisa até encontrar algo que tenha o p-value que permita publicar uma dada asserção. Eis uma excelente crítica a isto no cartoon seguinte:

Tradução resumida: uma pessoa afirma que um dado doce (digamos, pintarolas) causa acne. São chamados os cientistas para investigar. Depois de feita a investigação, os cientistas dizem que não há relação (p-value maior que 5%). A pessoa então alega que afinal deve ser apenas pintarolas de uma dada cor que causam o acne. Os cientistas testam então de forma independente cada uma das 20 cores possíveis das pintarolas, e no meio de todos os testes surgem as pintarolas verdes cujo p-value é inferior aos 5%! É então publicado um estudo segundo o qual as pintarolas verdes causam acne. Note-se a ironia de se terem feito 20 testes, pelo que 5% corresponde à probabilidade de encontrar por acaso num deles um padrão inexistente…

(Quando se fazem múltiplas comparações é necessário corrigir o p-value para valores mais baixos em concordância com o número de comparações realizado, algo que raramente é feito e que é difícil de controlar por quem revê os artigos submetidos, visto que podem apenas avaliar aquilo que está escrito, sendo provável que no manuscrito só se refira o teste que conduziu à verificação em causa, sem mencionar todos os outros testes infrutíferos).

Já nos cruzámos aqui com uma multitude de problemas, mas há mais. Para simplificar, volto ao exemplo anterior sobre o tabaco e o cancro: quantos indivíduos devemos considerar no estudo sobre o cancro para chegar a conclusões aceitáveis? Cem? Mil? (Note-se que se estivermos a estudar, por exemplo, uma doença rara, simplesmente não temos acesso a tais números.) Assumimos que os dois grupos, fumadores e não fumadores, têm que ser semelhantes em todos os aspectos exceptuando esse factor que queremos comparar. Acham que tal é possível? É fácil conseguir um igual número de mulheres e homens em cada um dos grupos para que uma possível correlação de cancro com o sexo do indivíduo não altere os resultados, ou que a média de idades seja semelhante, mas haverá muitos outros factores a considerar! Factores esses que podem estar inter-relacionados! Terão os homens dos dois grupos igual média de idades, igual acesso a serviços de saúde, estilo de vida semelhante, profissões semelhantes, estatuto social semelhante, etc? Note-se que em média tudo até pode parecer bem equilibrado, porém dentro de cada grupo poderemos criar subgrupos com tendências díspares. Além disso, existem diferentes fumadores: os que fumam pouco há muito tempo, os que fumam muito há pouco, etc. O que é fumar muito por dia? O que é fumar há muito tempo? Pode-se também considerar que quem fuma tem maior tendência a fazer uma outra coisa a qual poderia ser a verdadeira causa do cancro. Existem milhentas hipóteses que têm que ser simplesmente desprezadas em estudos deste género! Espero, por isso, que fique bem claro que um estudo estatístico não dispensa de forma alguma um estudo mais fundamental que tente compreender de que forma é que X induz Y. Até lá há apenas indícios. Recordemos também mais uma vez que correlação não implica causalidade!

Também devemos ter em consideração o quão “forte” é um dado efeito, e não apenas se o “efeito” existe. Em 2013 foi publicado na Nature um artigo segundo o qual casais que se tinham conhecido online tinham relações mais duradoiras e felizes que aqueles que se tinham conhecido offline. Os p-values eram extremamente reduzidos, o que parecia indicar que o efeito existia mesmo… Talvez, mas a verdade é que essa diferença traduzia-se em duas taxas de divórcio muito próximas, cerca de 6% e 8% respectivamente. É idiota frisar a diferença se se desvalorizar a magnitude da mesma.

Infelizmente, quem faz os estudos muitas vezes tem apenas um conhecimento muito limitado de estatística, pelo que muitos nem compreendem os erros que estão a cometer. Outros têm noção que algo está errado, mas sentem-se conformados com o facto de ser assim o “sistema”, estando apenas a dar o seu contributo com base naquilo que está ao seu alcance. É claro que com isto não estou a advogar que se acabe com estudos de carácter estatístico, trata-se antes de tentar consciencializar toda a gente para as limitações inerentes a este tipo de estudos. Por outro lado, o problema por vezes ocorre não no estudo original, mas antes nas notícias e estudos subsequentes: como referido temos os jornalistas que transmitem incorrectamente a informação ao público; e temos os cientistas a perseguir ideias assumindo como verdade algo que era apenas sugestivo num estudo anterior!

Na terceira parte deste artigo irei abordar o problema da replicabilidade.

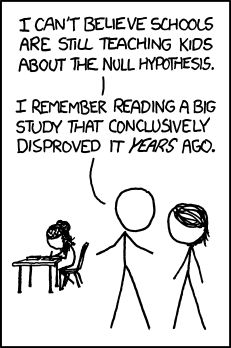

Tradução: “Não posso acreditar que as escolas ainda estejam a ensinar as crianças sobre a hipótese nula. Recordo-me de ter lido um grande estudo há uns anos que a refutava de forma conclusiva.”

1 ping

[…] primeira e segunda parte falei-vos de múltiplos problemas que perturbam a ciência actual, nomeadamente na forma como […]